推倒萬億參數大模型內存墻 從第一性原理看神經網絡量化、數據處理與存儲支持

隨著人工智能模型的參數規模突破萬億,內存墻成為訓練和部署大型神經網絡的關鍵瓶頸。本文從第一性原理出發,深入剖析神經網絡量化的理論基礎與實踐路徑,并結合數據處理與存儲支持服務,探討如何高效突破內存限制,推動大模型技術的可持續發展。

一、內存墻的挑戰與根源

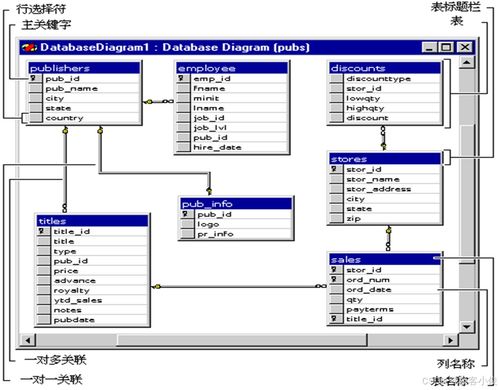

內存墻是指模型在訓練和推理過程中,由于參數數量龐大,導致內存帶寬和容量成為性能的主要限制因素。以萬億參數模型為例,如果使用32位浮點數存儲,僅參數就需占用約4TB內存,遠超當前硬件設備的常規配置。這不僅增加硬件成本,還拖慢計算速度,限制模型在邊緣設備上的部署。其根源在于傳統浮點表示法在精度和效率之間的不平衡,亟需通過量化技術優化。

二、神經網絡量化的第一性原理

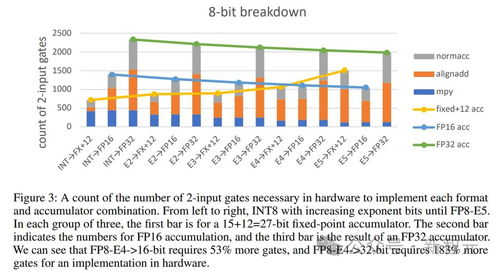

量化旨在將高精度浮點參數轉換為低精度整數或定點數,從而減少內存占用和計算開銷。從信息論和數值分析的角度,量化可以視為一種有損壓縮過程,核心在于在保持模型性能的前提下,最小化信息損失。

- 理論基礎:量化基于分布假設和誤差容忍性。神經網絡的權重和激活值通常服從高斯或拉普拉斯分布,通過非均勻量化(如對數量化)或均勻量化,可以保留關鍵信息。第一性原理要求我們回歸本質:量化誤差的傳播必須控制在模型容錯范圍內,這涉及梯度分析、損失函數敏感度評估等。

- 實踐方法:包括后訓練量化(PTQ)和量化感知訓練(QAT)。PTQ直接對預訓練模型進行量化,適用于快速部署;QAT在訓練過程中模擬量化效應,提升模型魯棒性。例如,將32位浮點量化為8位整數,可減少75%的內存占用,同時通過校準技術維持準確率。

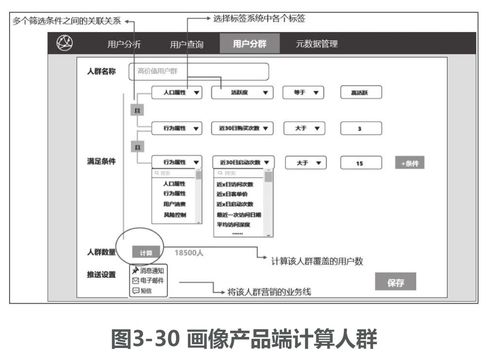

三、數據處理的關鍵角色

高質量的數據處理是量化成功的前提。數據預處理、增強和歸一化能夠優化數值分布,減少量化帶來的偏差。例如,通過數據標準化將輸入值縮放到固定范圍,可以避免異常值對量化區間的干擾。數據流水線設計需與量化策略協同,確保訓練和推理階段的一致性。

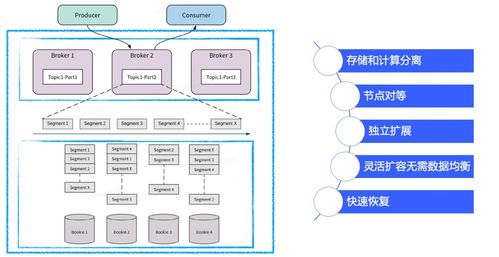

四、存儲支持服務的創新

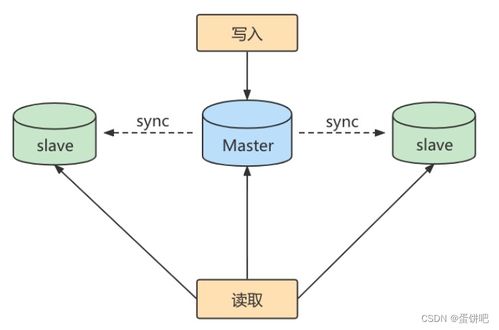

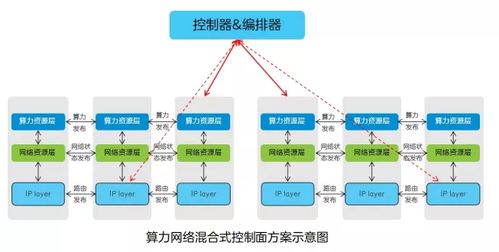

面對海量參數,分布式存儲和高效緩存機制至關重要。云原生存儲服務(如對象存儲和內存數據庫)提供彈性擴展能力,結合量化后的緊湊表示,可大幅降低存儲成本。例如,采用分層存儲架構,將高頻訪問參數置于高速內存,低頻參數存儲于低成本介質。新興的非易失性內存(NVM)技術有望進一步打破帶寬瓶頸。

五、未來展望與總結

神經網絡量化并非萬能鑰匙,需與模型壓縮、稀疏化等技術結合。從第一性原理出發,我們應持續探索量化極限,例如1位二值網絡的潛力。跨學科合作(如硬件-算法協同設計)將推動內存墻的徹底瓦解。通過量化、數據處理和存儲服務的深度融合,萬億參數大模型有望在資源受限環境中實現高效部署,開啟AI新紀元。

如若轉載,請注明出處:http://m.hrbxjj.cn/product/43.html

更新時間:2026-01-08 02:53:56