vivo pulsar萬億級消息處理實踐 數據發送原理解析、性能調優與存儲服務支撐

在當今大數據與實時計算的浪潮下,消息隊列作為系統解耦、流量削峰和異步通信的核心組件,其處理能力直接關系到企業數據平臺的穩定與效率。vivo基于Apache Pulsar構建了支撐萬億級消息流轉的處理平臺,本文將深入解析其數據發送的核心原理、關鍵性能調優策略以及底層數據處理與存儲服務的支撐體系。

一、 數據發送原理解析:從客戶端到Broker的旅程

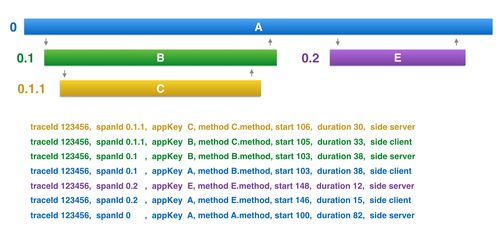

vivo Pulsar平臺的數據發送流程,是一個高效、可靠的分布式過程。其核心基于Pulsar的“發布-訂閱”模型,并針對生產環境進行了深度優化。

- 生產者客戶端工作機制:生產者(Producer)與Pulsar集群中的某個Broker建立TCP長連接。消息并非直接發送給最終的存儲節點,而是先發送給一個負責該Topic的Broker(Leader Broker)。客戶端內置了負載均衡與故障轉移機制,能自動發現并切換至健康的Broker。在發送前,消息會在客戶端進行批量(Batching)聚合,并支持異步發送、內存隊列緩存等機制,極大提升了吞吐量。

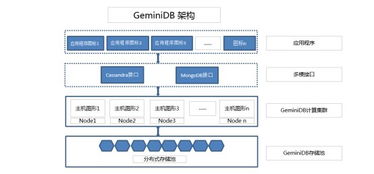

- Broker層的處理與分發:接收消息的Broker充當了無狀態的路由層。它首先驗證生產者的權限和Topic的配置,隨后將消息寫入一個高性能的持久化寫入緩沖區(Managed Ledger的寫緩存)。幾乎Broker會立即將消息分發給所有已連接的消費者(Readers),實現低延遲的推送。持久化操作則由后臺線程異步完成,實現了寫入路徑與持久化路徑的解耦,這是Pulsar高吞吐的關鍵設計之一。

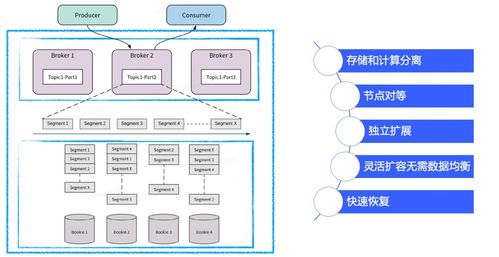

- BookKeeper的持久化存儲:Broker將消息的持久化任務委托給Apache BookKeeper。BookKeeper是一個專為日志流存儲設計的分布式存儲系統。它將一個Topic分區(Ledger)的數據條帶化(Striping)寫入多個物理Bookie節點,既保證了數據的高可用與強一致性(通過Quorum寫入協議),又通過并行I/O提升了寫入性能。這種存儲與計算分離的架構,使得Broker可以輕松水平擴展,而存儲層獨立擴展。

二、 性能調優實踐:通往萬億級處理能力的關鍵

面對海量消息場景,vivo團隊從多個維度對Pulsar集群進行了系統性調優。

- 生產者端調優:

- 批量發送(Batching):合理調整

batchingMaxMessages、batchingMaxPublishDelay參數,在吞吐量與延遲之間取得最佳平衡。對于高吞吐場景,增大批量大小;對于低延遲場景,則減小批量或關閉批量。

- 壓縮(Compression):啟用Snappy或ZSTD等壓縮算法,顯著減少網絡傳輸與存儲成本,提升有效吞吐。

- 異步與隊列:采用異步發送模式,并適當調大生產者隊列大小(

maxPendingMessages),以應對瞬間流量高峰,避免生產者阻塞。

- Broker與BookKeeper調優:

- 資源分配:確保Broker擁有充足的堆內外內存。增大Managed Ledger的讀寫緩存大小,減少與BookKeeper的磁盤交互頻率。

- Bookie磁盤優化:為Bookie節點配置多磁盤目錄(journal磁盤與ledger磁盤分離),使用高性能SSD,并優化操作系統I/O調度參數(如使用deadline/noop調度器),最大化磁盤IOPS與吞吐。

- 網絡與GC優化:優化Linux內核網絡參數(如TCP緩沖區大小),并針對JVM垃圾回收器(如G1 GC)進行精細化調參,減少GC停頓對高并發讀寫的影響。

- 架構層面優化:

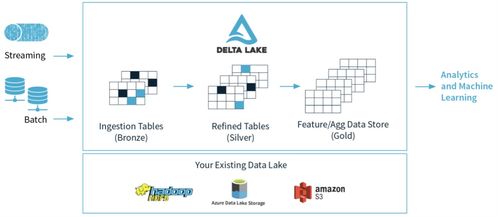

- 分層存儲(Tiered Storage):將冷數據從昂貴的BookKeeper存儲自動卸載到對象存儲(如S3、OSS),大幅降低長期存儲成本,同時保持對歷史數據的透明訪問能力。

- 地理復制(Geo-Replication):跨地域部署集群并配置異步復制,在保障數據容災與異地就近消費的不對原始集群的寫入性能造成顯著影響。

三、 數據處理與存儲支持服務:生態與穩定性基石

萬億級消息流的順暢處理,離不開周邊數據處理與強大的存儲服務支撐。

- 實時計算集成:vivo將Pulsar與Flink、Spark Streaming等流計算引擎深度集成。Pulsar提供了精確一次(Exactly-Once)語義保障、按時間戳回溯讀取(Message Retention & TTL)等特性,使得實時計算作業能可靠、靈活地處理消息流,支撐實時風控、用戶行為分析等關鍵業務。

- 統一的消息存儲服務:Pulsar的“流”與“隊列”統一模型,使得一套系統能同時支持傳統隊列場景和持久化日志流場景。其無限Topic分區能力和分層存儲,為業務提供了近乎無限的、成本可控的消息存儲能力,成為公司級的數據流通總線。

- 監控與運維支撐體系:

- 全方位監控:構建了涵蓋Broker/Bookie節點資源(CPU、內存、磁盤IO、網絡)、JVM狀態、消息堆積、端到端延遲等指標的立體監控告警體系。

- 自動化運維:針對Topic的自動擴縮容、基于預測的容量規劃、故障節點的自動隔離與恢復等,開發了自動化運維平臺,保障了集群的長期穩定運行和高可用性。

- Schema Registry:集成Schema Registry服務,對消息格式進行集中管理和演進控制,保障了上下游系統數據格式的一致性,減少了數據解析錯誤。

###

vivo在Pulsar萬億級消息處理上的實踐表明,通過深入理解其“存儲計算分離”和“分層架構”的核心設計,結合從客戶端到服務端、從硬件到軟件的全鏈路系統性調優,并構建完善的數據生態與運維支撐體系,Apache Pulsar完全有能力勝任超大規模、超高可用的企業級消息平臺角色。這一實踐不僅保障了vivo內部業務的流暢運行,也為業界提供了可借鑒的、經過生產環境驗證的大型消息平臺建設方案。

如若轉載,請注明出處:http://m.hrbxjj.cn/product/46.html

更新時間:2026-01-08 08:35:41